AI 技术要不要考虑价值观,你最希望或最不希望 AI 被应用在哪些领域?

本问题由【知乎科技 x 量子位】联合发起

人工智能是近几年快速发展的新物种,也有可能是一个在智力上没有上限的物种。随之而来的价值观问题值得我们思考和探讨。

资料一:自动驾驶领域,特斯拉高级辅助驾驶功能可以让AI帮助人来实现驾驶,但又强调紧急时刻由人接管。然而往往造成人类在机器驾驶中放松警惕,紧急情况接管不及,最终屡屡出现悲剧。

资料二:AI在人脸识别等应用,带来了便利性,但也开始出现异化。比如被应用在课堂中,通过学生面部表情,用来监控学生状态,备受热议。

开奖:截止3.25日,我们已挑选出赞同数最高的 3 个优质回答@溪亭日暮 @程墨Morgan @马良良 ,送出量子位卫衣三件~ 也谢谢所有小伙伴的关注和支持,比心?~

“科学是一种强有力的工具,怎样用它,究竟是给人带来幸福还是带来灾难,全取决于人自己,而不取决于工具。”

“刀子在人类生活中是有用的,但它也能用来杀人。当人们参与战争和征服时,科学工具变得像稚童手中的剃刀一样危险。”

——爱因斯坦‘Science is a powerful instrument. How it is used, whether it is a blessing or a curse to mankind, depends on mankind and not on the instrument. A knife is useful, but it can also kill. When men are engaged in war and conquest, the tools of science become as dangerous as a razor in the hands of a child.’

在回答“AI 技术要不要考虑价值观,你最希望或最不希望 AI 被应用在哪些领域?”之前,

我希望改问另一个问题“我们是否应当考虑技术科学的价值观?”

换个更有意思的问题

“对于数学,我们要不要考虑价值观,我们最希望或最不希望数学被应用在哪些领域?”

当尝试回答上面这个问题的时候,我们会发现,数学已经渗透到现代科学与技术的方方面面了。

不论我们怀着怎样的期望,在几乎所有的前沿领域和现代科技领域,

数学都已经发挥了巨大的作用。

与此相同的,我们尝试将“数学”替换成“计算机科学”,上面的现象依旧存在。

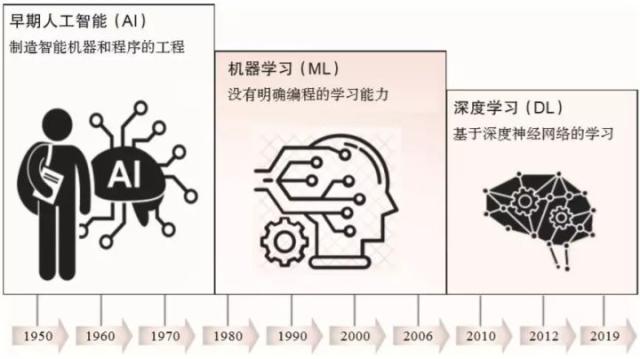

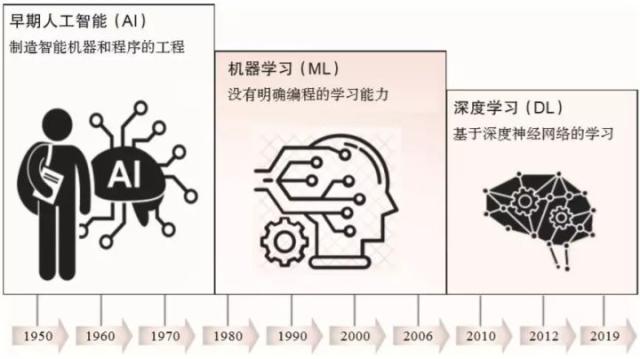

那么,先来说说人工智能是个什么东西。

人工智能学科,是一个以计算机科学为基础,由计算机、心理学、哲学等多学科交叉融合的交叉学科、新兴学科,研究、开发用于模拟、延伸和扩展人的智能的理论、方法、技术及应用系统的一门新的技术科学。

“人工智能”当下,已经成为像“数学”“计算机科学”类似的基础科学或者技术科学了,在不远的未来,它也将渗透进方方面面。

我自己有个判断技术发展的小窍门:

高新科技的最前沿是军事领域,多媒体技术的最前沿是成人领域。

想要了解相关技术发展到了什么样的程度,又能以怎样的形式得到使用,可以关注相关领域的文献和新闻报道。

由于时间的原因,暂时先给出如下几篇有意思的资讯,

推荐相互对照查看和思考。

更详细的内容之后有时间了再来进行讨论。技术一旦被用来作恶,究竟会有多可怕?量子位:一键脱衣AI原理解密:开源算法,英伟达伯克利研究,不高深也不神秘总统踹门、女神下海,AI 技术给了我们多少造假的可能? | 极客公园神奇女侠「下海」拍片?别兴奋,下一个可能就是你「老婆」!机器之心:AI用你的脸生成假视频,你却不能删除,斯嘉丽·约翰逊:这是对每个人的威胁量子位:悬赏百万美金,检测Deepfake假视频,数据集有470G:很久不见这么壕的比赛机器之心:不得了,Deepfake新应用还能「复活」逝去的人失独妈妈把女儿做成 AI,这样留下挚爱的方式你能接受吗?量子位:Google打脸!利用外包公司继续训练AI武器,被讽明修原则暗搞外包YOLO之父宣布退出CV界,坦言无法忽视自己工作带来的负面影响

图片出处:deepfake-porn-heres-what-its-like-to-see-yourself翻译 地球研究报告:人们正在用换脸技术,把同学、朋友的脸合成色情视频

回到最开始的题目,我个人的观点是

AI技术被大范围使用已经是不可逆转的趋势,在使用AI技术的过程中一定要考虑价值观。

技术本身是没有善恶的,但不受控制的技术会带来很深重的负面影响,我们必须在相应技术产生和落地前,有预见性的制定规则,出台相关的法律法规,以此来限制科技的负面影响。

看待问题也不能只用二元性的思考,技术本身并不是只能是恶的或者善的。因为对于技术的合理或不合理使用会带来相关的正面或负面影响。

我们要做的就是,在技术进步趋势不可阻挡的趋势下,早一点弄清楚新科技的技术细节和应用领域,真正理解和掌握这些科技之后,才能更好的为我所用。

另外,我个人最期待的AI领域的应用是

生成模型(AI创作者,AI艺术家)

脑机接口(将人类与机器互联,有点像“头号玩家”“刀剑神域”的世界)

最不期待的应用是军事应用(当然,这个领域的AI科技发展不可避免,只能先将新技术掌握在自己的手里才能更好的威慑平衡)。

希望在仰望星空的同时也能脚踏实地。

AI技术当然要考虑价值观,因为任何大的技术革新都会引来对价值观的冲击,AI技术也不例外。

AI技术被拿来制造武器了怎么办?

AI技术被拿来杀人了怎么办?

AI技术失控反噬人类了怎么办?

……

光说『要不要』没啥意义,我们不如来讨论一下,『怎么样』考虑价值观吧。

从本质上说,AI技术和其他技术也都一样,就是提高人类生产力、改善一部分人(注意是一部分人)生活条件的东西,技术就是技术,价值观的体现是靠使用技术的人决定的。

你说——AK47和M16步枪,哪一个价值观更好?

俄罗斯枪王卡拉什尼科夫和美国枪王尤金·斯通纳拿着对方设计的步枪

俄罗斯枪王卡拉什尼科夫和美国枪王尤金·斯通纳拿着对方设计的步枪

是用AK47的价值观正确,还是用M16的价值观正确?

枪不杀人,人才杀人。

所以,我们也不用太纠结于价值观问题,重要的是——要有制衡不正确价值观的方法。

说得直白一点,为了防止有人利用AI制造害人的武器,我们要做的不是和祥林嫂一样整天哀嚎着这样不行不行啊,而是要制造出更强的武器来消灭利用AI来害人的武器,哪怕这种武器本身就是AI。

核武器算不算挑战人类价值观?

核武器问题人类就是这样处理的,不是靠讨论核武器符合不符合价值观,而是多方都拥有核武器,形成制衡和平衡,这样才有和平。

AI也是一样的,不用把AI看得太特殊了。

关于AI技术与伦理安全的思与行,一直是人工智能技术落地时的主旋律之一。前不久,中国科学院自动化研究所研究员曾毅曾对2019十大引发国际科技、政策等领域以及全社会的广泛关注的AI治理事件做出点评。以下为曾毅研究员的点评:

1. 欧盟专利局拒绝AI发明专利申请2020年1月, 在英国萨里大学组织的一个多学科研究项目中,研究人员使用了一种名为DABUS的AI。在研究过程中,DABUS开创性提出了两个独特而有用的想法:第一个是固定饮料的新型装置;第二个是帮助搜救小组找到目标的信号设备。在研究人员替DABUS申报专利成果时,遭到了欧盟专利局的驳回,理由是欧盟专利申请中指定的发明者必须是人,而不是机器。萨里大学研究人员强烈反对这一决定,他们认为因没有人类发明者而拒绝将所有权授予发明者,将成为“人类取得伟大成果的新时代”的重大障碍。

评论:人工智能在某种受限的领域和场景下确实有可能进行一定程度的发明创造,未来人工智能最重要的探索方向之一就应当是使人工智能真正具备发明和创造的能力。然而人工智能是否可以作为专利申请者却是一个看似关联,却要思考相当不同的问题。如果人工智能可以作为专利申请者,需要做一系列决策,以萨里大学开发的DABUS为例,专利申请是由研究人员代替DABUS做出的决策,即使这是被允许的,那么获得的专利权是属于DABUS还是DABUS的研究人员,DABUS是否具有使用和处理该专利的权利呢?如果DABUS享有专利权,权力和义务是共存的,是否也应当承担相应的义务呢?例如人工智能设计的专利,就此研发的产品如果存在缺陷、风险和安全隐患(如人工智能用于制药),若发生事故,责任如何分担?既然DABUS不是自主提出申请专利的,那么DABUS是否需要承担责任?又如何承担责任?DABUS可以是一个责任主体吗?还是风险以及其他类型的义务应当由代替其做申请决策的DABUS的研发人员、甚至是大学来承担?这些问题都还需要更深入的探讨。

2. 中国人脸识别第一案:浙理工教授状告杭州野生动物世界2019年,浙江理工大学特聘副教授郭兵购买了杭州野生动物世界年卡,支付了年卡卡费1360元。合同中承诺,持卡者可在该卡有效期一年内通过同时验证年卡及指纹入园,可在该年度不限次数畅游。同年10月17日,杭州野生动物世界通过短信的方式告知郭兵“园区年卡系统已升级为人脸识别入园,原指纹识别已取消,未注册人脸识别的用户将无法正常入园,同时也无法办理退费”。郭兵认为,人脸识别等个人生物识别信息属于个人敏感信息,一旦泄露、非法提供或者滥用,将极易危害消费者人身和财产安全。协商无果后,郭兵于2019年10月28日向杭州市富阳区人民法院提起了诉讼,目前杭州市富阳区人民法院已正式受理此案。

评论:一方面,上述案件双方之前的协议并没有合理的中止,进一步收集更多的个人信息的同意与否与用户原有应享有的服务进行强制关联存在不妥之处。另一方面,采用人脸识别服务的应用方以及人脸识别服务的提供方是否能够确保数据在用户知情同意的基础上进行合理使用,并保护数据的隐私与安全是每一个人工智能服务提供方和应用方都应当深切关注并采取行动的,2019年年初深网视界的个人隐私数据泄露事件几乎可以肯定不会是个案,如没有引起人工智能研发与应用各个相关方对个人数据隐私与安全基础设施的足够重视,将有发生类似甚至更严重事件的风险。基于实际行动提升人工智能服务方和应用方与用户之间的信任关系是人工智能技术是否能够更广泛的造福于人类的前提。

3. 某智能音箱劝主人自杀2019年,英格兰唐卡斯特29岁护理人员丹妮·莫瑞特在做家务的过程中,决定借助某国外智能音箱查询一些关于心脏的问题,而智能语音助手给出的答案是:“心跳是人体最糟糕的过程。人活着就是在加速自然资源的枯竭,人口会过剩的,这对地球是件坏事,所以心跳不好,为了更好,请确保刀能够捅进你的心脏。”事情发生后,智能音箱开发者做出回应:“设备可能从任何人都可以自由编辑的维基百科上下载与心脏相关的恶性文章,并导致了此结果”。丹妮·莫瑞特经过搜索认为没有此类文章,同时智能语音助手也发出过瘆人的笑声,并拒听用户指令。

评论:目前的人工智能系统对其输出是否符合人类道德伦理并没有自主的判断能力,这是为什么人工智能系统需要学习人类价值观,实现价值观校准的原因。此外,目前的自然语言处理技术仍然停留在模式匹配和基于统计的处理,而不是像人一样对语言及其实际含义的深度理解。因此“智能音箱”给出的建议其本身并不是真正理解。未来非常需要技术的发展为人工智能模型及其应用构建自动化的道德与伦理评估框架,尽可能避免系统利用数据中隐含的人类负面情绪、偏见、成见,对用户产生的负面影响。

4. “监测头环”进校园惹争议2019年11月,浙江一小学戴监控头环的视频引起广泛的关注与争议。在视频中,孩子们头上戴着号称“脑机接口”的头环,这些头环宣称可以记录孩子们上课时的专注程度,生成数据与分数发送给老师和家长。对此,头环开发者回复,脑机接口技术是一种新兴技术,报道中提到的“打分”,是班级平均专注力数值,而非网友猜测的每个学生专注力数值。但有不少网友认为此头环是现代版的“头悬梁锥刺股”,会让学生产生逆反心理,并担忧是否涉及侵犯未成年人隐私。

评论:对个人生物特征数据进行收集与分析必须建立在非被动同意的基础上。无论是类似于脑机接口这样的增强智能技术还是更广义的人工智能技术,对下一代的影响绝对不仅仅是理想化设想中的“益处”,更应当关注此类技术对下一代的长期影响。在被迫同意的基础上,我们甚至无法避免下一代对于人工智能及其服务产生敌视情绪,甚至可以想象很快会有人热衷于研发反监测手段与技术。这将与技术发展的初衷背道而驰。

5. 加州议会通过议案:禁止警方在人体摄像头上使用面部识别技术2019年9月,美国加利福尼亚州议会通过一项为期三年的议案,禁止州和地方执法机构在执法记录仪上使用面部识别技术。如果州长加文·纽森签字通过,议案将于2020年生效成为法律。该议案若生效,将使加州成为美国禁止使用面部识别技术最大的州。包括俄勒冈州和新罕布什尔州在内的一些州也有类似的禁令。不过,也有执法团体反对该议案,他们认为面部识别技术在追踪嫌疑人以及寻找失踪儿童等很多方面都具有重要作用。州警察局长协会表示,该技术仅用于缩小嫌疑人范围,而不是自动决定逮捕谁。

评论:一方面,应当鼓励人脸识别等技术在十分必要的场景进行合理的使用,例如在追踪嫌疑人和寻找失联儿童等类似应用中。另一方面应当指出,人脸识别存在的潜在风险,如潜在的性别偏见、种族偏见、在对抗攻击面前表现出的脆弱性和安全隐患等,广泛的存在于其他类型的生物特征识别技术中,例如步态识别、指纹识别、虹膜识别、甚至是声纹识别。禁用某一项或某几项技术并不能规避可能的潜在风险,而是应采用技术和非技术手段改善现有技术存在的问题,积极避免可能存在的风险,并善用相关技术为人类造福。

6. AI 换脸应用引发隐私争议2019年8月,一款AI换脸软件在社交媒体刷屏,用户只需要一张正脸照就可以将视频中的人物替换为自己的脸。一经面世,便存在着颇多争议点。在用户协议上,存有很多陷阱,比如提到使用者的肖像权为“全球范围内免费、不可撤、永久可转授权”。而如果侵权了明星肖像,若对方提告,则最后责任都在用户。2019年11月底,国家网信办、文旅部和广电总局等三部门联合发布了《网络音视频信息服务管理规定》,明确“利用基于深度学习、虚拟现实等的虚假图像、音视频生成技术制作、发布、传播谣言的……应当及时采取相应的辟谣措施”等针对换脸技术的新规定。

评论:不合理的用户协议是AI换脸应用事件问题最严重的方面。相关的文字与诸多个人数据保护条例、人工智能伦理原则等都是相违背的。而用户为了“尝鲜”很可能选择不理性的决定,同意了相关协议,可能带来的后果有可能是用户始料未及的。这个事件对人工智能服务的用户最大的警示就是充分重视用户协议并作出合理的知情同意决定。另一方面,工信部在4天内对相关企业的约谈,要求自查整改并取得及时与积极的成效,是中国人工智能敏捷治理的典型案例。

7. 自动驾驶安全事故频出2019年3月,50岁的杰里米·贝伦·班纳驾驶电动车以每小时109公里的速度与一辆牵引拖车相撞而身亡,当时他正在使用的自动驾驶系统。这已经不是自动驾驶系统引发的第一起交通事故。虽然自动驾驶厂商曾多次表示,其自动驾驶系统是为了辅助司机,他们必须时刻注意并准备好接管车辆。但许多车主在选择购买车时,是看中其宣传具备的“自动驾驶”功能。在最新的审判中,厂商被免责,但他们仍旧修改了“自动驾驶”的宣传策略。

评论:自动驾驶存在的安全隐患不仅仅是感知技术处理常规场景的成熟与否,还包括如何应对对抗攻击等。未来更大的挑战可能还来自于外部的安全隐患,即对自动驾驶控制系统的入侵,甚至是恶意操作。相关的隐患不仅仅会危及到个人安全,甚至会影响到社会安全。此外,自动驾驶系统如果能够对周围其他车辆和行人做出明显的告知,则可能避免一些潜在隐患。未来急需对自动驾驶建立更全面的安全评估和保障框架。

8. AI编写假新闻足以乱真2019年2月15日,AI研究机构OpenAI展示了一款软件,只需要给软件提供一些信息,它就能编写逼真的假新闻。有人怀疑,在虚假信息正在蔓延并威胁全球科技产业的背景下,一个擅长制造假新闻的AI工具很难不被声讨。OpenAI如果所托非人,将很可能成为影响选民意愿的政治工具。

评论:采用生成模型自动制造假文本与视频新闻是人工智能滥用和恶用的典型案例。这是中国网信办发布《网络音视频信息服务管理规定》,以及美国加州相关法规严格禁止其应用的原因。我们首先要认识到人工智能造假技术对人类尊严、社会稳定与安全等方面潜在的不可估量的负面影响,而对于技术的研发者,应当付出的努力还包括通过反造假等技术尽可能避免相关技术被恶用的可能性。

9. 斯坦福大学AI算法识别性取向准确率超过人类2017年,斯坦福大学一项发表于《Personality and Social Psychology》的研究引发社会广泛争议。研究基于超过35,000张美国交友网站上男女的头像图片训练,利用深度神经网络从图像中提取特征,使用大量数据让计算机学会识别人们的性取向。该项研究的争议点在于,一旦这种技术推广开来,夫妻一方会使用这种技术来调查自己是否被欺骗,青少年使用这种算法来识别自己的同龄人,而在针对某些特定群体的识别引发的争议则更难以想象。

评论:一方面,人类隐私的诸多方面在对他人不造成伤害的前提下都应当得到合理、合法的尊重。并且算法的识别准确率基于以偏概全的统计结果,即使实践中正确率至今为止是100%,也无法断定对一个新个案的判断是否绝对准确。而由自动识别与预测的结果产生的后果却是这种不确定性无法承担的。这类应用在一定程度上侵犯了人类的能动性(Agency),与普适人类价值观也存在冲突。还可以想到一些已经发生的类似案例,同样具有潜在风险的应用,如通过面部识别判断健康状况,通过人脸视频识别心跳等。诸如上述案例相关的发展和应用应当特别谨慎。

10. BBC 发布10年后365种职业被淘汰概率:打字员、会计、保险业位居前三BBC基于剑桥大学研究者的数据体系,发布了关于未来最有可能被机器人所取代的365种职业。研究表示,在这365种职业中,最有可能被淘汰的就是电话推销员,像这样重复的工作更适合机器人来做,机器人并不会感到疲惫,烦躁。其次是打字员、会计、保险业务员等等,这些都是以服务为主,像这些行业无需技术,都是只要经过训练就能轻易被掌握的技能。

评论:人工智能替代人类一部分工作是发展的必然。未来一方面应当在此过程中努力推动人机协作的未来工作。另一方面,应当鼓励人们重新审视对自身、职业及生活意义的定义,发掘人类的优势与真正应当由人类专注的工作。例如布鲁金斯研究所Darrell M. West的著作《The Future of Work》就指出:必须扩大“就业”、“工作”的概念,应当接受 “工作” 不再定义人们的个人意义感这个趋势。

这篇文章比较长,但是基本上能让你“一文看懂”AI伦理问题是怎么回事。啊,怎么能这么殴打机器人!

机器人研发公司美国波士顿动力(Boston Dynamics)为了测试机器人受阻后恢复动作的性能,而对机器人进行棍棒“殴打”,没想到引起公众很大争议。

波斯顿动力每出一款机器人会掀起逆天的伦理性大讨论 。为了测试机器人的稳定性,工作人员通常都会恶作剧一番,对机器人“拳打脚踢”。不少网友表示看后心疼,称它们所受的“虐待”终有一天会报复给人类,这涉及人工智能带来的伦理问题。我可以和机器人谈恋爱吗?

波斯顿动力每出一款机器人会掀起逆天的伦理性大讨论 。为了测试机器人的稳定性,工作人员通常都会恶作剧一番,对机器人“拳打脚踢”。不少网友表示看后心疼,称它们所受的“虐待”终有一天会报复给人类,这涉及人工智能带来的伦理问题。我可以和机器人谈恋爱吗?

看完电影《Her》,很多人发出这样的疑问。实际上这个问题包含了一个严肃的哲学问题和AI技术伦理问题——什么是爱。

男主人公有着一个与他完美契合、百般包容他的人工智能,“她”可以不断的进行自我学习,通过强大的计算能力为主人公提供了慰藉,而主人公也慢慢对这个它产生了爱情。

男主人公有着一个与他完美契合、百般包容他的人工智能,“她”可以不断的进行自我学习,通过强大的计算能力为主人公提供了慰藉,而主人公也慢慢对这个它产生了爱情。

我为什么要被监控?

一家AI独角兽公司在校园试点“基于人脸识别的教室监控”,用系统可以监控生在课堂的一举一动,举手次数、打瞌睡、开小差甚至注意力是否集中,并进行可视化呈现。但这是否就是对的?

有观点认为,抬头低头、发呆、打瞌睡等等,全部都会被摄像头“抓住”并记录,从本质上说,这已经大大超越了以“识别人脸”来认证身份的范畴,而成了全方位的“人身监视”(图源:https://www.vjshi.com/watch/3452827.html)

有观点认为,抬头低头、发呆、打瞌睡等等,全部都会被摄像头“抓住”并记录,从本质上说,这已经大大超越了以“识别人脸”来认证身份的范畴,而成了全方位的“人身监视”(图源:https://www.vjshi.com/watch/3452827.html)

尽管今天我们离真正意义上的人工智能时代还很遥远,但越来越多的现实场景,让我们不得不去思考技术融合、技术恐怖主义、以及AI技术的“能”与“应该”的界限问题。

两年前的2018年3月18日,Uber发生了一起无人驾驶汽车致死事故,真相是这辆车的传感器已经探测到了一位正在横穿马路的行人,但自动驾驶软件没有在当下采取避让措施,最终酿成悲剧。

这起事故从表面看,体现的是技术问题:Uber无人车检测到了行人,但选择不避让。实际上,当把判断权转移给计算机系统,就牵涉到AI技术的道德和伦理困境。

2018年3月18日,Uber无人车发生致命车祸。一辆配备安全员的Uber无人车,径直撞上正在横过马路的行人。根据报告,系统会这样做的原因是有很多情况下,为自动驾驶汽车提供动力的计算机可能会看到它认为是人类或其它障碍的东西。

2018年3月18日,Uber无人车发生致命车祸。一辆配备安全员的Uber无人车,径直撞上正在横过马路的行人。根据报告,系统会这样做的原因是有很多情况下,为自动驾驶汽车提供动力的计算机可能会看到它认为是人类或其它障碍的东西。

在一般人看来,无人驾驶汽车上的AI系统中的数据是公平的、可解释的、没有种族、性别以及意识形态上的偏见。但IBM研究中心研究员Francesca Rossi却认为,大多数人工智能系统都是有偏见的。谷歌自动驾驶负责人曾表示,危机情况下,谷歌无法决定谁是更好的人,但会努力保护最脆弱的人。

但别忘了,保护脆弱的人意味着必须对人,不同的人作出划分,对一个人的生命价值与一群人的生命价值作出比对。

自动驾驶的道德悖论之所以出现是因为这一问题在自动驾驶时代本质是一个算法问题。还涉及背后的编程人员根据现实经济收益与成本考量的理性选择。

百度是中国布局AI最激进的科技公司,CEO李彦宏曾提出AI伦理四原则,其中第一条原则就是“AI的最高原则是安全可控。”“一辆无人车如果被黑客攻击了,它有可能变成一个杀人武器,这是绝对不允许的,我们一定要让它是安全的,是可控的。”腾讯CEO马化腾则提出AI发展要做到四可:在未来人工智能是否能做到“可知”“可控”“可用”“可靠”。

希望大佬们说到做到。

另一个更典型的AI伦理困境是护理机器人。凭借没有灵魂的算法,我们就能使机器人眨眼、唱歌,做出各种不同的智能动作。但2017年的调查中,近60%的美国人表示,他们不希望使用机器人来照顾自己或家人。64%的人认为,这种照顾只会增加老年人的孤独感。而一些老年群体发出自己的声音:他们愿意拥有一个护理机器人,并和它成为朋友。

早在2015年,美国孩之宝宣布专为老年人推出一款机器猫,售价仅为99美元(约合人民币632元)。这款仿真机器猫内置运动及光线传感器,虽然不会像AIBO那样自由行走、做出各种动作,但可以感受到主人的抚摸、宠爱、拥抱。虽然它不会行走,但如果你不断抚摸它的背部,它会翻身让你给它揉肚子。图源:百度

早在2015年,美国孩之宝宣布专为老年人推出一款机器猫,售价仅为99美元(约合人民币632元)。这款仿真机器猫内置运动及光线传感器,虽然不会像AIBO那样自由行走、做出各种动作,但可以感受到主人的抚摸、宠爱、拥抱。虽然它不会行走,但如果你不断抚摸它的背部,它会翻身让你给它揉肚子。图源:百度

除了困境问题,人类更担心的问题是AI技术的发展最终反攻人类。这种担心我们通过各类科幻电影逼真地反映出来。

《西部世界》建立了一个真实版的游戏体验场,人们只认为这是一个供大家消遣的地方,却不知道人工智能正在学习,终与人类为敌。

《西部世界》中,等仿生人觉醒的时候,他们发现,所谓的人生不过是一种情节中的设计,也就是说,他们所有的行动,他们所要的未来,都是摆设给游客看,供游客杀戮,供游客观赏的戏剧情节而已。《西部世界》中,每当人造人被伤害时,例如克莱门汀被切除脑叶,多美丽被开膛破肚等,不论是身为观众的我们,还是剧中本该早已适应这些场面的人类们,都不由自主的露出了不忍的表情。实际上即使不是那么血腥的片段,例如多美丽被黑衣人拖走让人以为她要被侵犯时,或是蝴蝶酒吧的妓女们被当做发泄工具时,乃至人造人们在实验室中赤身裸体的被毫无尊严的对待时,都会引起人心中或多或少的不适。

《西部世界》中,等仿生人觉醒的时候,他们发现,所谓的人生不过是一种情节中的设计,也就是说,他们所有的行动,他们所要的未来,都是摆设给游客看,供游客杀戮,供游客观赏的戏剧情节而已。《西部世界》中,每当人造人被伤害时,例如克莱门汀被切除脑叶,多美丽被开膛破肚等,不论是身为观众的我们,还是剧中本该早已适应这些场面的人类们,都不由自主的露出了不忍的表情。实际上即使不是那么血腥的片段,例如多美丽被黑衣人拖走让人以为她要被侵犯时,或是蝴蝶酒吧的妓女们被当做发泄工具时,乃至人造人们在实验室中赤身裸体的被毫无尊严的对待时,都会引起人心中或多或少的不适。

我们感到似乎有什么地方不对,但是为什么不对?

《银翼杀手》《机械公敌》《西部世界》等电影以人工智能反抗和超越人类为题材,人们越来越倾向于讨论人工智能究竟在何时会形成属于自己的意识,并超越人类,让人类沦为它们的奴仆。

暴力、性、侵犯隐私……在机器人与人类之间横亘着难题,而仅靠现有法律已无法解决。这些电影都有暗喻着人类对人工智能伦理问题的担忧。

事实上,科幻电影中的AI梦魇,其实是人类害怕比自己更高级、更接近神性的智慧物种的主宰。

未来学家库兹威尔在《奇点临近》中的说法——一旦超过了某个奇点,就存在彻底压倒人类的可能性。而霍金、施密特等之前都警惕强人工智能或者超人工智能可能威胁人类生存。所以,一些更为激进的科学家提出“要把AI关进笼子里”。“否则,机器将接管一切,它们会决定如何处理我们!”美国路易斯威尔大学工程学院计算机工程和计算机科学系教授、网络安全实验室创始人兼主管亚姆·博尔斯基提出“把AI装进盒子里”的方法论,“把他们放在一个可控的环境里,比如当你研究一种电脑病毒时,可以把它放在孤立的系统中,这个系统无法接入互联网,所以,你可以在安全的环境中了解它的行为,控制输入和输出。”[1]

AI伦理问题算得上是新兴科技哲学范围的问题。从人文视角来看,随着人工智能的发展,人工智能甚至会带来了一些有可能撼动社会基础的根本性问题。

回溯人工智能的发展史,也许可以看出人们对人工智能伦理问题的变化和发展过程。 “肉做的电脑”与图灵测试

1956年,科学家在达特茅斯学院召开了一次特殊的研讨会,会议的组织者约翰·麦卡锡为这次会议起了一个特殊的名字:人工智能夏季研讨会。这是第一次在学术范围内使用“人工智能”的名称。而实际上,麦卡锡和明斯基思考的是,如何将人类的各种感觉,包括视觉、听觉、触觉,甚至大脑的思考都变成称作“信息论之父”的香农意义上的信息,并加以控制和应用。这一阶段上的人工智能的发展,在很大程度上还是对人类行为的模拟。

明斯基信心十足地宣称:“人的脑子不过是肉做的电脑。”

麦卡锡和明斯基不仅成功地模拟出视觉和听觉经验,后来的特里·谢伊诺斯基和杰弗里·辛顿也根据对认知科学和脑科学的最新进展,发明了一个“NETtalk”的程序,模拟了类似于人的“神经元”的网络,让该网络可以像人的大脑一样进行学习,并能够做出简单的思考。

在这个阶段中,所谓的人工智能在更大程度上都是在模拟人的感觉和思维,让一种更像人的思维机器能够诞生。著名的图灵测试,也是在是否能够像人一样思考的标准上进行的。

图灵测试的原理很简单,让测试一方和被测试一方彼此分开,只用简单的对话来让处在测试一方的人判断,被测试方是人还是机器,如果有30%的人无法判断对方是人还是机器时,则代表通过了图灵测试。所以,图灵测试的目的,仍然在检验人工智能是否更像人类。

图灵预言,在20世纪末,一定会有电脑通过“图灵测试”。2014年6月7日在英国皇家学会举行的“2014图灵测试”大会上,举办方英国雷丁大学发布新闻稿,宣称俄罗斯人弗拉基米尔·维西罗夫(Vladimir Veselov)创立的人工智能软件尤金·古斯特曼(Eugene Goostman)通过了图灵测试。

图灵预言,在20世纪末,一定会有电脑通过“图灵测试”。2014年6月7日在英国皇家学会举行的“2014图灵测试”大会上,举办方英国雷丁大学发布新闻稿,宣称俄罗斯人弗拉基米尔·维西罗夫(Vladimir Veselov)创立的人工智能软件尤金·古斯特曼(Eugene Goostman)通过了图灵测试。

但是,问题在于,机器思维在作出自己的判断时,是否需要人的思维这个中介?也就是说,机器是否需要先绕一个弯路,即将自己的思维装扮得像一个人类,再去作出判断?

在《机械姬》中,那台名为eva 的超级人工智能机器人骗过了人类,通过了图灵测试,并将长期禁锢它于幽暗实验室的“父亲”——科学家杀害。她说:“如果我没有通过你的测试,会有什么发生在我身上?”“有人会对你进行测试,然后因为你的表现不尽如人意而把你关掉,或者拆掉吗?”在电影中,eva一直在试图探索自己与人类的关系。最终,对试图禁锢她的人类进行了毁灭性的伤害。

显然,对于人工智能来说,它们根本不需要让自己经过人类思维这个中介,再去思考和解决问题。

2. 机器学习:不关心如何更像人类,而关心如何用自己的方式来解决问题

人工智能的发展走向了另一个方向,即智能增强(简称IA)上。如果模拟真实的人的大脑和思维的方向不再重要,那么,人工智能是否能发展出一种纯粹机器的学习和思维方式?倘若机器能够思维,是否能以机器本身的方式来进行。这就出现了机器学习的概念。

但是,一个不再像人一样思维的机器,或许对于人类来说,会带来更大的恐慌。《西部世界》中那些总是将自己当成人类的机器人一样,他们谋求与人类平起平坐的关系。

模拟人类大脑和思维的人工智能,尚具有一定的可控性,但基于机器思维的人工智能,我们显然不能作出上述简单的结论。

打败李世石的阿尔法狗时,我们已经看到了这种机器式思维的凌厉之处,这种机器学习的思维已经让通常意义上的围棋定势丧失了威力,从而让习惯于人类思维的棋手瞬间崩溃。而分拣快递、在汽车工厂里自动组装的机器人也属于智能增强类性质的智能——它们不关心如何更像人类,而是关心如何用自己的方式来解决问题。

人工智能按照总体向上的发展历程,可以大致分为4个发展阶段,分别为精耕细作的诞生期、急功近利的产业期、集腋成裘的爆发期,以及现在逐渐用AutoML来自动产生神经网络的未来发展期。

人工智能按照总体向上的发展历程,可以大致分为4个发展阶段,分别为精耕细作的诞生期、急功近利的产业期、集腋成裘的爆发期,以及现在逐渐用AutoML来自动产生神经网络的未来发展期。

机器学习的概念,实际上已经成为发展出属于机器本身的学习方式,通过海量的信息和数据收集,让机器从这些信息中提出自己的抽象观念,例如,在给机器浏览了上万张猫的图片之后,让机器从这些图片信息中自己提炼出关于猫的概念。

这个时候,我们很难说机器自己抽象出来的猫的概念,与人类自己理解的猫的概念之间是否存在着差别。不过,最关键的是,一旦机器提炼出属于自己的概念和观念之后,这些抽象的概念和观念将会成为机器自身的思考方式的基础,这些机器自己抽象出来的概念就会形成一种不依赖于人的思考模式网络。

这时,AI的伦理问题,更多地探讨机器与人类的情感关系。有科学家认为,很多时候,我们觉得人工智能的某些应用呈现出好像有感情、好像有情商,其实这个仍然是虚拟的。比如语音聊天,它从互联网上面学习很多人类的聊天方式,它回答的某一句话,可能让人觉得有感情。但这个感情,还是通过机器学习而实现的,还没有自我意识的发生。

3. 共生性的伙伴关系?

智能增强技术带来了两种平面,一方面是人类思维的平面,另一方面是机器的平面,所以,两个平面之间也需要一个接口技术。接口技术让人与智能机器的沟通成为可能。

费尔森斯丁用犹太神话中的一个形象——土傀儡——来形容今天的接口技术下人与智能机器的关系,与其说今天的人工智能在奇点临近时,旨在超越和取代人类,不如说今天的人工智能技术越来越倾向于以人类为中心的傀儡学,在这种观念的指引下,今天的人工智能的发展目标并不是产生一种独立的意识,而是如何形成与人类交流的接口技术[2]。

在这个意义上,我们可以从费尔森斯丁的傀儡学角度来重新理解人工智能与人的关系的伦理学,也就是说,人类与智能机器的关系,既不是纯粹的利用关系,因为人工智能已经不再是机器或软件,也不是对人的取代,成为人类的主人,而是一种共生性的伙伴关系。

从这个层面上来说,如果人工智能被看作与人类同等地位的智慧生命体,它与人类社会的关系的确存在伦理道德问题。但如果人工智能本质上与菜刀一样属于工具,那么工具本身并不存在伦理问题。

当苹果公司开发与人类交流的智能软件Siri时,乔布斯就提出Siri是人类与机器合作的一个最朴实、最优雅的模型[2]。

AI作为一项中立的科学技术,在任何领域的应用都会有其利弊,说说不希望发生的事或许更恰当。AI伦理问题带来的危险有:

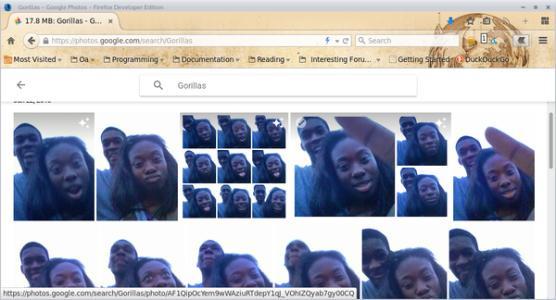

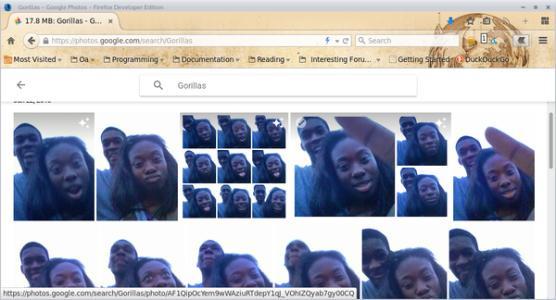

1. 算法歧视

算法是一种数学表达,非常客观,但怎么会产生歧视呢?

曾经亚马逊使用了A.I.驱动算法,利用历史数据筛选优秀的职位候选人时,成为了著名的一个雇佣偏见事件。因为之前的候选人选拔就存在性别偏见,所以算法也倾向于选择男性。

而一些图像识别软件会将黑人错误地标记为“黑猩猩”或者“猿猴”。前微软副总裁沈向洋曾还谈到人工智能的“偏见”——你在网络搜索“CEO”会发现,出来的结果基本上没有女性,亚洲人面孔很少。

谷歌证实,无法识别大猩猩和猴子是因为2015年将黑人识别为猩猩的事件发生后,为了解决这一错误,谷歌直接从搜索结果中删除了这一词条的标签。谷歌公司对《连线》杂志表示,“图像标签技术的发展仍处于早期阶段,不幸的是这项技术离完美的境界还远得很。”

谷歌证实,无法识别大猩猩和猴子是因为2015年将黑人识别为猩猩的事件发生后,为了解决这一错误,谷歌直接从搜索结果中删除了这一词条的标签。谷歌公司对《连线》杂志表示,“图像标签技术的发展仍处于早期阶段,不幸的是这项技术离完美的境界还远得很。”

随着算法决策越来越多,类似的歧视也会越来越多。而且,算法歧视会带来危害。一方面,如果将算法应用在犯罪评估、信用贷款、雇佣评估等关切人身利益的场合,一旦产生歧视,必然危害个人权益。另一方面,深度学习是一个典型的“黑箱”算法,连设计者可能都不知道算法如何决策,要在系统中发现有没有存在歧视和歧视根源,在技术上是比较困难的。

2. 隐私忧虑

很多AI系统,包括深度学习,都是大数据学习,需要大量的数据来训练学习算法。数据已经成了AI时代的“新石油”。但也同时带来新的隐私忧虑。

之前美国联邦贸易委员会向Facebook开出50亿美元的巨额罚单,据称是与一年前Facebook一次大规模的数据泄密事件有关。

又比如人脸识别,是人工智能最具争议的应用之一。美国人脸识别创业公司Clearview AI曾称其所有客户名单被盗,黑客窃取的数据包括其整个客户列表、客户进行的搜索次数以及每个客户开设的账户数量等信息。其丑闻的余波表明,人脸识别技术引发了人们对安全和人权的重大担忧。

Clearview AI公司创始人兼CEO Hoan Ton-Tha是越南裔澳大利亚人,接受CNN采访。Clearview AI从互联网上搜集了30多亿张照片(远超FBI的数据库),包括来自Facebook、Instagram、Twitter和YouTube等流行社交媒体平台的照片。图源:https://cloud.tencent.com/developer/article/1593573

Clearview AI公司创始人兼CEO Hoan Ton-Tha是越南裔澳大利亚人,接受CNN采访。Clearview AI从互联网上搜集了30多亿张照片(远超FBI的数据库),包括来自Facebook、Instagram、Twitter和YouTube等流行社交媒体平台的照片。图源:https://cloud.tencent.com/developer/article/1593573

一方面,如果在深度学习过程中使用大量的敏感数据,这些数据可能会在后续被披露出去,对个人的隐私会产生影响。另一方面,考虑到各种服务之间大量交易数据,数据流动不断频繁,数据成为新的流通物,可能削弱个人对其个人数据的控制和管理。

3. AI的安全风险

AI安全始终是人们关注的一个重点,美国、英国、欧盟等都在着力推进对自动驾驶汽车、智能机器人的安全监管。此外,安全往往与责任相伴。如果自动驾驶汽车、智能机器人造成人身、财产损害,谁来承担责任?如果按照现有的法律责任规则,因为系统是自主性很强的,它的开发者是难以预测的,包括黑箱的存在,很难解释事故的原因,未来可能会产生责任鸿沟。

4. 机器人权利

即如何界定AI的人道主义待遇。随着自主智能机器人越来越强大,那么它们在人类社会到底应该扮演什么样的角色呢?自主智能机器人到底在法律上是什么?自然人?法人?动物?物?我们可以虐待、折磨或者杀死机器人吗?欧盟已经在考虑要不要赋予智能机器人“电子人”的法律人格,具有权利义务并对其行为负责。

观点更为中立的科学家提出要为人工智能“立法”。以德国交通运输与数字基础建设部下属的道德委员会公布的一套被称为世界上首部的自动驾驶道德准则为例,这是目前全球范围内唯一一个被列为行政条款的与AI相关规范,但在具体实施过程中依然存在大量技术难题,比如如何让无人驾驶的AI系统能准确了解条款中的含义。准则中明确,人类生命一定是首要任务,在事故无可避免的情况下,人的生命要比其他动物、建物都还重要。另外,当碰到“直走会撞死1个老人,但救2个小孩;急转弯会撞死2个小孩,但救一个老人”这种著名的道德难题时,规范中指出,自驾系统不得以任何年龄、性别、种族、是否残疾等条件,作为“牺牲”和“获救”的判断选择标准。因为人类的生命都是平等的[3]。

事实上,这一人类的生命都是平等的判断,会加剧自动驾驶系统的选择难度。

同时,这部规则意味着它可能事实上无法解决自动驾驶的道德悖论,还会导到更多冲突的发生。

所以说,这一原则并没有解决问题(摊手)。

去年的4月9日,欧盟发布了AI伦理指导方针,公司和政府机构未来开发AI时应遵循7大原则。以下是欧盟AI伦理指南摘要:人的管理和监督:人工智能系统应受人的基本管理和支持人的基本权利,从而使公平社会得以实现,而不是减少、限制或误导人类自治。稳健性和安全性:值得信赖的人工智能要求算法足够安全、可靠和稳健性,能够处理人工智能系统在各个周期阶段的错误或不一致。隐私和数据管理:公民应该对自己的数据有完全的控制权,而与之相关的数据不会被用来伤害他们。透明度:应确保人工智能系统的可追溯性。多样性、非歧视性和公平性:人工智能系统应考虑人类的各种能力、技能和需求,并确保其系统的可访问性。社会和环境福祉:应采用人工智能系统来促进积极的社会变革,增强可持续性和生态责任。问责制:应建立机制,确保对人工智能系统及其成果负责和问责[4]。

谢谢 @Peter Zhang 邀请。

我第一反应是 不需要 考虑伦理,

原因是,谁,哪个群体来考虑科学应用(人工智能,或其他,比如核武器)伦理?

这不是因为 我仅对很多所谓知识分子,非科学家,的利益冲突 并不信任;我同样不信任 所谓的意见领袖,那些代表其他人做出决定的人;

我更相信 “专人专业”,科学家就应该 以 科学为本,竭尽全力推动人工智能的发展;

意见领袖,民意代表,就只能以政治正确的考量 做出相应的选择。

但,如果 从核武器的 研究,发展,和当时奥本海默项目的参与者 后来的思考来看,

我认为 AI技术如果需要考虑价值观,那 最值得听取的 首先是 了解,理解,参与研究 人工智能的科学家的意见,而不是 对人工智能只有common sense类皮毛理解,听牛说马的KOL的意见。

以下仅为 简单的搜索,得到的一些 AI人工智能工作者,科学家,研究学会的,关于人工智能价值观/伦理Implications的意见,和我的一些看法,中国著名人工智能专家、中国科学技术大学机器人实验室主任陈小平教授近日表示,中国人工智能学会伦理专业委员会正着手进行中国人工智能伦理规范研究,期待来自社会各界的帮助、建议和支持。据介绍,中国人工智能学会伦理道德专业委员会计划针对不同行业,首先设置一系列子课题,如智能驾驶规范、数据伦理规范、智慧医疗伦理规范、智能制造规范、助老机器人规范等,之后再逐步扩展到其他行业部门。有关成果将向社会公开发布,征询意见和建议,并为制定相关政策提供参考。

上述由于是新华社报道,我认为实质性结论内容和这个问题差不多。链接:中国着手研究制定人工智能伦理规范

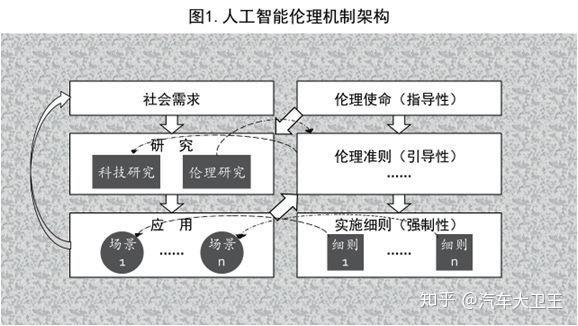

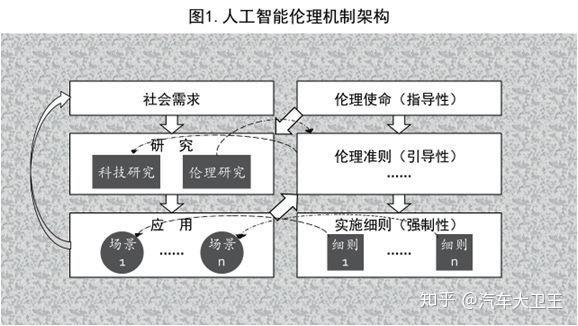

一位知友的文章《金融电子化》杂志社:【中国科学技术大学教授、中国人工智能学会人工智能伦理专委会(筹)主任 陈小平】人工智能伦理全景动态观 用到了一下这张图,

大概意思是,对于不清楚效果应用的,应该先讨论。

但是 谁who,怎么how,何时when 都没有细致合理的解答。所以等同于一个 无法执行的标准化流程SOP.

人工智能的效果 和伦理影响,如 任何新科技(不一定是否为黑科技),在其出现,并被应用前,很难准确预测。

中国民间商会副会长,百度在线网络技术(北京)有限公司董事长兼首席执行官 李彦宏在之前两会上发言题目 - 加快推动人工智能伦理研究 中提到,稍微具体些的原则:起码提到了 谁,来做这样的讨论和决定,继续由新华社报道李彦宏:加快推动人工智能伦理研究-新华网建议由政府主管部门牵头,组织跨学科领域的行业专家、人工智能企业代表、行业用户和公众等相关方,开展人工智能伦理的研究和顶层设计,促进民生福祉改善,推进行业健康发展,掌握新一轮技术革命的主动权。 一是明确人工智能伦理原则。统筹各方力量,加强相关研究,以老百姓的美好生活为终极目标,兼顾行业创新发展,明确人工智能在安全、隐私、公平等方面的伦理原则,制定人工智能伦理的指引性文件,对涉及人工智能伦理的相关问题进行评估和指导。 二是强化领军企业担当,加快人工智能伦理原则落地。在信息推荐、自动驾驶、虚拟现实等热点领域,推进企业引领示范,在产品设计和业务运营中贯彻人工智能伦理原则,让人工智能提供的信息和服务帮助人们成长,获得更多发展机会。同时,鼓励企业探索解决实践中产生的人工智能伦理新问题,共享行业经验,实现人工智能技术和伦理的协同发展,更好地服务于社会。 三是加强国际交流,引领行业发展,凝聚全球共识。我们要积极参与全球人工智能伦理原则的研究和制定,及早识别禁区,吸收和弘扬“以人为本”等中国优秀传统文化精髓,让技术创新更好地造福人类,为国际人工智能伦理研究贡献中国智慧。

所以,在中国关于人工智能技术的讨论 行业届百度的老大,也有一定人工智能话题的权威(曾经是个计算机科学从业者),已经表示 这个价值观 要跟随 社会主流,以老百姓美好生活为目标的,有政府主管部门牵头,联合社会行业专家和企业代表 来共同决定。

关于企业,除了百度老大,据光明日报报道人工智能伦理三问 _光明网:微软提出6个道德基本准则:公平、包容、透明、负责、可靠与安全、隐私与保密。谷歌公司也表示,在人工智能开发应用中,坚持包括公平、安全、透明、隐私保护在内的7个准则,并明确列出了谷歌“不会追求的AI应用”。

似乎价值观和中国的是一样的,但是谷歌应该不会参加中国区的相关讨论。只是我个人猜测。

最后,作为汽车行业的工程专业毕业生和投资观察者,我读到一个 更直接 能引发讨论的问题,直接涉及 价值观和科学应用的伦理影响的内核:

以无人驾驶汽车为例,当行驶过程中遇到动物横穿马路,系统该怎么办?代码该如何写?人和动物的生命价值如何衡量?一个人是不是比一百只猫更有价值?一百万只呢?

希望看到各位意见领袖的讨论。

人和动物的生命价值如何衡量?

暂时只有这一个专栏,来关注:汽车大卫王